| Muster: Open Report |

| Muster: Premium Report (PDF) |

Verfahren

Das Verfahren Open CAR-16 entspricht der deutschsprachigen Übersetzung der 16-Item-Version eines Leistungstests, welcher aus dem SAPA-Projekt, begründet durch beiden amerikanischen Persönlichkeitspsychologen William Revelle und David M. Condon, hervorgegangen ist. Unter dem Titel International Cognitive Ability Resources (I-CAR) wurde im Rahmen dieses breit angelegten und internationalen Projekts unter anderem ein Public-Domain-Instrumentarium zur Messung von kognitiven Fähigkeiten zu sozialwissenschaftlichen Forschungszwecken angelegt und validiert. Mit ihren Arbeiten konnten die Forscher aufzeigen (Revelle & Condon, 2014; Kirkegaard & Nordbjerg, 2015), dass eine kurze und nicht lizenzrechtlich geschützte Messung kognitiver Leistungsfähigkeiten mit Aufgaben ohne Zeitbeschränkung möglich ist und ausreichend stark mit anderen Massen der Intelligenz und weiteren Leistungskriterien korreliert ist.

Der Test umfasst 16 Aufgaben, die sich in vier Aufgabentypen unterteilen lassen, welche zusammengefasst eine Schätzung der allgemeinen Intelligenz ermöglichen sollen. Die vier Aufgabentypen lassen sich wie folgt umschreiben:

- Dreidimensionale Rotationen

- Buchstabenreihen

- Schlussfolgerndes Denken mit Matrizen

- Verbales schlussfolgerndes Denken

Bei der Konzeption dieser Aufgabentypen wurde unter Berücksichtigung der Zielsetzung, die Testaufgaben telemetrisch darbieten zu können, folgende Kriterien besonders berücksichtigt:

- Verschiedenartigkeit der Aufgabentypen

- Vermeidung zeitkritischer Aufgaben

- Vermeidung von Aufgabenstellungen, deren Lösungen oder Lösungswege ungehindert und rasch durch andere Ressourcen erschliessbar sind

Dadurch eignet sich der resultierende Test besonders für die Darbietung als Online-Test.

Beschreibung der Leistungsdimensionen und Beispielaufgaben

| Beispielaufgaben als PDF |

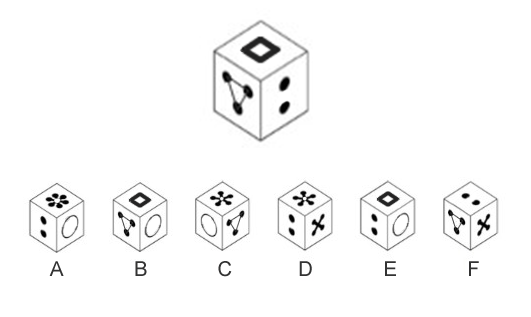

1. Dreidimensionale Rotationen

Bei den Items mit räumlichen Rotationen werden den Testprobanden sechs mögliche Würfelansichten präsentiert, die daraufhin beurteilt werden sollen, ob sie der rotierten Ansicht eines Zielobjekts entsprechen können.

Beispiel

Auf jeder Seite eines Würfels sind unterschiedliche Symbole abgebildet. Pro Würfel kommt jedes Symbol nur einmal vor. Wählen Sie denjenigen Würfel aus A bis F, welcher eine Rotation/Drehung des obersten Würfels ist:

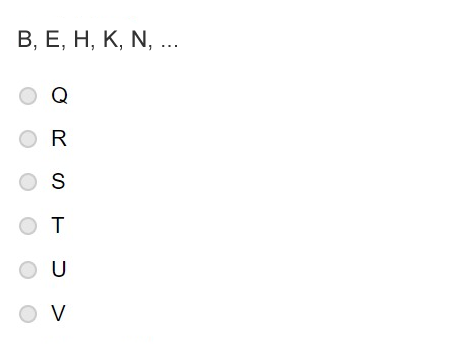

2. Buchstabenreihen

Jeweils fünfstellige Buchstabenreihen sollen durch die Auswahl eines sechsten Elements (aus sechs Auswahlmöglichkeiten) ergänzt werden. Dazu muss die innewohnende Regel erkannt und fortgesetzt werden.

Beispiel

Im Folgenden sehen Sie eine Reihe von Buchstaben. Welcher der weiter unten zur Auswahl stehenden Buchstaben folgt als nächstes?

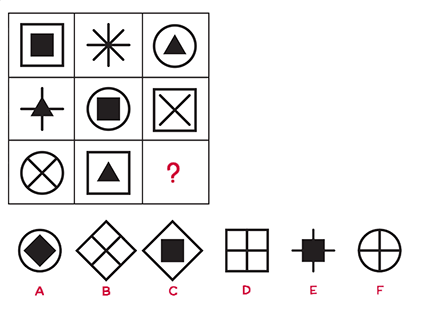

3. Schlussfolgerndes Denken mit Matrizen

Die vier Items zum schlussfolgernden Denken mit Matrizen gleichen den weitverbreiteten Stimuli aus Ravens Progressiven Matrizen. Es handelt sich um 3×3-Felder von geometrischen Formen, wobei jeweils die neunte Form fehlt. Die Probanden werden angehalten, aus einer zusätzlichen Auswahl von sechs Formen diejenige auszuwählen, welche die 3×3-Felder am besten komplettieren.

Beispiel

Sie sehen eine Matrix mit acht Figuren, die nach einer bestimmten Regel aufgebaut ist. Eine Figur in der Matrix fehlt. Welches der weiter unten zur Auswahl stehenden Bilder A bis F passt nach der Regel an die Stelle mit dem Fragezeichen?

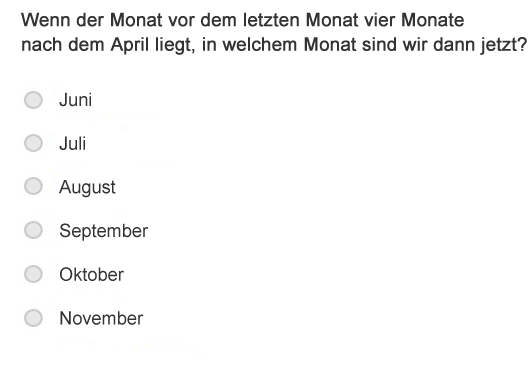

4. Verbales schlussfolgerndes Denken

Die vier verbalen Items stützen sich auf logische Zusammenhänge mit Bezug zu vokabularischem oder allgemeinem Wissen.

Beispiel

Einsatzbereich

Das Instrument richtet sich an erwachsene Personen, die ihre kognitiven Fähigkeiten in einem (laufbahn-/entwicklungs-)beraterischen und vertrauensvollen Setting erkunden möchten. Es muss den Probanden bewusst sein, dass sie die Ergebnisse durch Zuhilfenahme von Unterstützung oder Hilfsmitteln während der Durchführung beeinflussen und verzerren können, wodurch die Ergebnisse ihre Aussagekraft weitgehend verlieren. So ist es z.B. bei einer selbständigen Ferndurchführung möglich, die Durchführung zu unterbrechen und für die Lösung von einzelnen Aufgaben – entgegen den Test-Instruktionen zu Beginn – die Einschätzung weiterer Personen beizuziehen. Selbstredend geht die Validität von derart zustandekommenden Ergebnissen eines Leistungstests komplett verlustig.

Von einem Einsatz zu Selektionszwecken wird aufgrund der beschriebenen mangelnden Kontrolle der Durchführungsbedingungen im Online-Setting entsprechend nachdrücklich abgeraten.

Die Ergebnisse dürfen nur mit Bedacht und Vorsicht als Ausdruck allgemeiner Intelligenz gewertet werden: Im engeren Sinn misst der Test nur, wie geschickt die Probanden eine bestimmte Art von Aufgaben lösen. Es ist offensichtlich, dass andere massgebliche Facetten von Intelligenzleistungen gänzlich unberücksichtigt bleiben. Um eine adäquate Rückmeldung im beraterischen Setting zu unterstützen und typische Fehlinterpretationen im Zusammenhang von Intelligenzmessung zu vermeiden, wird auf die Berechnung eines “IQ-Werts” (basierend auf der IQ-Normskala) verzichtet. Stattdessen werden die Ergebnisse in Form von Prozenträngen bzw. Prozentwert-Bereichen dargeboten.

Obwohl die Validierung an Probanden von 14 bis 90 vorgenommen wurde, empfehlen wir die Durchführung erst ab einem Mindestalter von 16 Jahren. Wie Kirkegaard & Bjerrekær (2016) aufzeigen konnten, erweisen sich die Aufgaben in einer dänischen Übersetzung für Schüler und Schülerinnen unter 15-16 Jahren als zu schwierig.

Normen

Die Grundlage der Normierung bilden die Arbeiten von Condon und Revelle (2014) zur Entwicklung des I-CAR-Instrumentariums aus dem SAPA-Projekt. Es handelt sich um eine Reihe von Studien unter internationaler Beteiligung. Die Normen werden in einer ersten Phase der Abbildung innerhalb der Opentest-Plattform aus den englischsprachigen Studien übernommen. Aufgrund der wenig sprachsensitiven Formulierung und grossteils bildlich gestützter Darbietung der Leistungsaufgaben lässt sich diese Übertragung als vertretbar beurteilen. Insgesamt haben an den Studien mehr als 96’000 Personen aus 199 Ländern im Alter von 14 bis 90 Jahren teilgenommen. Für die Normierung der Fassung mit 16 Items, welche dem deutschsprachigen Open CAR-16 entspricht, wurde eine Teilstichprobe aus 4’574 Probanden eingesetzt.

Für den Test liegen keine geschlechtsspezifischen Normwerte vor.

Gütekriterien

Innerhalb der SAPA-Forschungsarbeiten konnte aufgezeigt werden, dass sich die 60 Items und vier Skalen aus dem I-CAR-Pool als valide Alternative zur kognitiven Leistungserfassung eignen und einsetzen lassen (Condon & Revelle, 2014). Für die englischsprachige Fassung mit 16 Items liegen die internen Konsistenzwerte für die vier Subskalen durchschnittlich bei 0.81 (Cronbach’s Alpha). Eine exakt gleich hohe interne Konsistenz zeigte sich auch bei der dänischen Übersetzung der Testfassung mit 16 Items (Kirkegaard & Nordbjerg, 2015).

Zur Kriteriumsvalidierung wurden die Test-Ergebnisse von Condon & Revelle (2014) mit den Ergebnissen aus den Teilbereichen Leseverständnis und Mathematik aus dem amerikanischen Scholastic Assessment Test (SAT) in Beziehung gesetzt. Dieser Test wird als Prädiktor für den Studienerfolg bei amerikanischen Studienbewerbern eingesetzt. Es zeigten sich Korrelationen in der Höhe von 0.59 zu den zusammengesetzten SAT-Scores (N=7’348). Zur Konstruktvalidierung wurden die Ergebnisse an einer kleinen Stichprobe von Studierenden (N=137) mit dem Shipley-2 Kurztest zur Intelligenzmessung verglichen. Nach den aufgrund der beobachteten Reliabilitäts- und Varianzeinschränkungen in der Studierendenstichprobe durchgeführten Attenuationskorrekturen konnten wahre Korrelationen in der Höhen von 0.81 und 0.82 zu den Subscores des Shipley2-Tests geschätzt werden.

Bearbeitungsdauer

Die Beantwortung der 16 Items nimmt in der Regel ca. 15-20 Minuten in Anspruch. Sehr sorgfältig antwortende Probanden können auch mehr Zeit beanspruchen. Obwohl für die Beantwortung innerhalb der Testplattform keine Zeitlimite vorgesehen ist, wird empfohlen, die Durchführung insgesamt nicht über maximal 30 Minuten auszudehnen. Alle Testprobanden erhalten vor der Testdurchführung über die Testplattform eine entsprechende Instruktion.